AUF DER ÜBERHOLSPUR –

DAS AUTO DES 21. JAHRHUNDERTS IST EIN MEDIUM

Gespräch mit Dr. Michael Schmidtke, Director Digital Communications, Bosch

Das autonome Fahren verändert die Rolle des Automobils: Das Kfz wird zum Arbeitszimmer, Kinoraum oder Fitness-Studio. Über Sprachdialogsysteme, Virtual Reality, immersive Storytelling im Auto und seine persönlichen Beobachtungen und Erfahrungen aus der digitalen Innovationswelt sprach ich mit dem Kommunikationsmanager Michael Schmidtke – ein Gespräch, das Lust macht auf einen gewaltigen aber hochspannenden Medienwandel im liebsten Kind des Deutschen.

In diesem Jahr steht ein Jubiläum in der Automobilbranche an: Vor 130 Jahren schob Berta Benz den dreirädrigen Benz Patent-Motorwagen Nummer 3 aus der Garage und unternahm die erste Fernfahrt von Mannheim nach Pforzheim. Bis dahin war die revolutionäre Erfindung ihres Mannes Carl Benz ein Ladenhüter – zahlendes Publikum blieb aus. Durch ihre mutige Tat, eine solche Strecke war bis dahin noch nie jemand mit einem Automobil gefahren, lieferte sie den Beweis, dass man mit dem Automobil bequem, sicher und relativ entspannt Langfahrten unternehmen konnte. Das Auto ist schon lange kein reines Vehikel mehr, um von A nach B zu kommen. Seit wann kann man denn vom Auto als Medium sprechen?

Nun, es kommt darauf an, wie ganzheitlich die Menschen kommunikativ in einem Auto angesprochen werden. Sicherlich war die Erfindung des Autoradios der erste Schritt, das Auto zu einem Medium zu machen. Seither ist einiges hinzugekommen: Surround-Sound-Anlagen, großflächige Touchscreens, Bordcomputer, Navigationsgeräte, Smartphones. Und jetzt passiert etwas Interessantes, was den medialen Charakter des Autos noch einmal deutlich erweitert: Wenn man nicht mehr selbst fährt, wird die Fahrerin oder der Fahrer zum Passagier und kann viel mehr Aufmerksamkeit anderen Dingen, wie z.B. dem „Medienkonsum“ widmen. In der Zukunft wird man irgendwann die Hand nicht mehr am Lenkrad haben müssen, hier spricht man dann vom sogenannten „Autonomielevel 5“, und spätestens dann wird das Auto zum primären Kommunikations- und Entertainmentraum.

Berta Benz hat das Auto aus der Garage geschoben, um eine Fahrt zu machen. Werden wir uns ins Auto setzen, um Medien zu konsumieren?

Das kann gut sein. In einer gewissen Phase meines Lebens bin ich sehr gerne Auto gefahren, weil da die beste Musik-Anlage drin war und weil ich auch ungestört Musik hören konnte. Das kann man sich in Zukunft natürlich auch bei anderen Entertainment-Angeboten vorstellen. Aber natürlich geht es nicht nur um Entertainment. Das Auto wird neben dem Zuhause und dem Büro zu einem dritten, wie ich finde immer interessanteren Lebensbereich.

Bosch-Studie zum Auto der Zukunft

Welche Technologien werden den „Fahrgastraum“ Auto vollends zu einem „Mediennutzungsraum“ machen? Als Informationsplattform kennen wir das Auto schon. Was steht uns da noch an Entwicklung bevor?

Es gibt heute beispielsweise schon Sensoren und Algorithmen, die erkennen ob ein Fahrer müde ist. Ein „Persönlicher Virtueller Assistent“ könnte dann zum Beispiel den Fahrer wach rütteln, die Frischluftzufuhr erhöhen oder dynamische Musik abspielen. In Zukunft werden sie aber noch ein sehr viel breiteres Spektrum an Daten nutzen können, etwa auf der Basis von Gesichtserkennung oder anderen sensorischen Daten, die der Fahrer oder die Fahrerin von sich erfasst haben möchte. Macht man im Auto ein „sehr müdes Gesicht“, kann so ein Persönlicher Virtueller Assistent einen fragen, ob man frische Luft wünscht. In einem Fahrzeug mit „Autonomielevel 5“ könnten dann Autofahrer solche biosensorische Daten theoretisch auch dafür einsetzen, das Entertainment im Auto zu verbessern oder optimale individuelle Arbeitsbedingungen im fahrenden Büro zu gestalten.

Sie haben Persönliche Virtuelle Assistenten als In-Car-Assistenten angesprochen. Wie werden die sich anfühlen? Werden das eher Bosch-Bots sein oder ein Mercedes-Bot? Oder werden wir gleich einen der Superbots von Alexa bis Cortana mit ins Auto nehmen? Was ist ihre persönliche Erfahrung und Einschätzung?

Aus meiner Sicht ist es noch nicht ausgemacht, dass „Superbots“ wie Google, Alexa, Siri und Cortana auch den Medienraum Auto übernehmen. Ich möchte an dieser Stelle noch einmal betonen, dass alle meine zukunftsgerichteten Beobachtungen in diesem Gespräch nicht als eine Indikation missverstanden werden, inwieweit Bosch oder andere in diese Richtung arbeiteten oder nicht. Das sind alles persönliche Einschätzungen, Beobachtungen und Szenarien. Grundsätzlich kann man aber schon sagen, dass sich eher die Technologien durchsetzen, die einen Nutzen für den Menschen haben und gleichzeitig den Menschen auch ermöglichen, sich die Technik für ihr Leben anzueignen. Und da sind nicht nur Angebote aus dem Silicon Valley interessant, sondern immer das Zusammenspiel verschiedener Anwendungen für den maximalen übergreifenden Nutzen. Dafür sollten Lösungen aus dem Auto idealerweise auch vernetzt mit anderen Lebensbereichen funktionieren, z.B. mit dem Smart Home. Nach meiner Einschätzung ist es unmöglich, dass ein Unternehmen in dieser vernetzten Welt eine solche übergreifende Vernetzungsleistung im Alleingang schafft. Da muss und wird auch eng zusammengearbeitet werden. So gibt es ganz verschiedene und immer breitere Industrieallianzen, um dem Nutzer einen umfassenden Gesamtnutzen zu ermöglichen.

Wie wollen Sie den Gesamtnutzen über das Auto hinaus in einer zunehmend vernetzten Welt verbessern?

Jederzeit ansprechbar: Der Küchen-Elf MyKie von BSH Hausgeräte. Ein Blueprint für einen PVR?

Man kann das jetzt schon in der Lebenswelt zuhause erfahren, also etwa im Wohnzimmer oder in der Küche. Dort gibt es schon erste persönliche Küchen-Assistenten, z.B. von BSH Hausgeräte das „Home Connect“-Konzept „Mykie“. Solche persönlichen Küchen-Assistenten können auf Vorlieben eingehen und sind mit der vernetzten Küche verbunden, vom Kühlschrank über den Ofen bis hin zum Saugroboter. So könnten Küchen-Assistenten beispielsweise basierend auf dem Kühlschrankinhalt ein Lieblingsrezept vorschlagen. Wenn man dann die Lebenswelten zuhause mit dem Auto vernetzt, kann man sich auch gut vorstellen, dass man bereits auf der Rückfahrt von der Arbeit mit der Planung des Abends und den entsprechenden Vorbereitungen des Abendessens beginnen kann. Es wäre doch äußerst praktisch, wenn man aus dem Auto heraus mit dem persönlichen Küchen-Assistenten schon einmal Kontakt aufnimmt und sich mit ihm berät, welches Rezept überhaupt gekocht werden kann.

Dann beginnt die Logistik für den Abend: Was brauche ich noch? So könnte der persönliche Küchen-Assistent online Zutaten kaufen. Wenn die Zeit für die Lieferung nicht reichen sollte, könnte ein vernetztes Auto auch entsprechend am nächsten Geschäft halten, das die nötigen Zutaten vorrätig hat, und dann rechtzeitig auch schon – wieder über den virtuellen Küchen-Assistenten – den Ofen vorheizen lassen. Die Verknüpfung all dieser unterschiedlichen Informationen spielt eine ganz zentrale Rolle – und das funktioniert an vielen Stellen auch heute schon, zumindest als Prototyp oder Konzept.

Allerdings gibt es da auch noch viel zu tun. Wenn der optimale Nutzen erst durch Vernetzung entstehen kann, dann können Persönliche Virtuelle Assistenten nicht nur auf der Ebene von Einzelgeräten angesiedelt sein. Das Gesamterlebnis und der gesamte Handlungsstrang ist entscheidend: Vom Kühlschrank über das Weinregal, die Speisekammer bis zur Preferred Supplier-Liste, dem Navigationsgerät im Auto usw.

Werden wir es mit einem Bot-Ökosystem zu tun haben, bei dem unterschiedliche Bots mit einander reden werden?

Ein solches Szenario ist denkbar. Das ist in der vernetzten Welt heute ja schon der Fall, wenn beispielsweise gewisse Apps auf andere Apps zugreifen dürfen. Das neue an den Ökosystemen von Virtuellen Assistenten ist, dass der Mensch auch eine gewisse Beziehung dazu aufbauen kann. Dabei spielt auch eine emotionale Einschätzungsfähigkeit der Systeme eine Rolle. Virtuelle Assistenten könnten zum Beispiel bestimmte Grundgestimmtheiten der Nutzer wahrnehmen und maßgeschneidert auf sie eingehen. Das ist dann etwas völlig anderes, als Regelkreise, die sich gegenseitige automatisiert steuern – etwa das Einschalten der Heizung, wenn die Temperatur einen gewissen Schwellenwert unterschreitet. In Zukunft könnte es psychosoziale Szenarien geben, aufgrund derer ein Assistent entscheidet, welche Informationen er uns wo zukommen lässt – ob im Auto oder sagen wir auf der Kaffee-Tasse.

Ein solches Szenario findet natürlich nur unter ganz bestimmten Voraussetzungen eine breitere Akzeptanz. Wichtig ist aus meiner Sicht, dass der Nutzer stets die Kontrolle behält, dass er also Zuordnungen wieder ändern kann und nicht dem Diktat der Virtuellen Assistenten ausgeliefert ist. Ich möchte jedenfalls mein Leben weiter nach meinen Bedürfnissen gestalten können.

Dann ist der Blick auf das Auto als Medium eine verengte Perspektive?

Nicht notwendigerweise, aber ja: Das Auto ist natürlich nur ein Teil unserer Lebenswelt. Es könnte aber auch eine erweiterte „digitale Dienstsphäre“ geben, die uns durch Persönliche Virtuelle Assistenten an vielen Stellen unseres Alltags umgeben und unterstützen könnte: Dies könnte dann morgens beginnen, wenn wir aufstehen, mit dem Blick in den „intelligenten Spiegel“, der bereits die ersten Nachrichten oder den Wetterbericht anzeigt. Als nächstes könnten wir dann der „intelligenten Kaffeetasse“ begegnen, die uns weitere Neuigkeiten je nach persönlicher Stimmung vorliest. Wir steigen ins Auto und so weiter – das alles sind potentielle Medien. Und wir erwarten natürlich, dass wir nicht überall dasselbe erzählt oder angezeigt bekommen. Vieles könnte zu einem Medium werden – auch das Auto. Oder besser zu einen Dialogmedium, denn durch die Sprachsteuerungen und „Conversational UIs“ ist ein sehr viel höhere Grad an Interaktion möglich als wir dies von Medien wie Zeitung, Radio oder TV heute noch gewohnt sind.

Welche Rolle wird denn Virtual Reality im Auto spielen?

VR hat immer die große Herausforderung, dass sich der Nutzer in einem quasi autistischen Kommunikationsraum befindet. Man hat eine VR-Brille, und so lange man auf diese VR-Brille angewiesen ist, befindet man sich in einer in sich gekapselten Welt. Ich glaube aber, dass das mehr und mehr aufbricht. Man spricht im Auto schon lange von Augmented oder Mixed Reality. Aber das interessante ist, wie diese Elemente in der Realität manifest werden. Im Auto ist das ganz konkret im Bereich der Gestik und Haptik zu sehen. Auf der CES hat Bosch vorgestellt, wie man etwa haptisches Feedback im Auto einsetzen kann. Man kann aber auch an Hologramme denken. Auf der Digitalkonferenz SXSW in Austin habe ich gerade wieder faszinierende Anwendungen von Holgrammen gesehen, die eben in die reale Welt Abbilder aus der digitalen Welt projizieren. Es ist sehr spannend, was da gerade entsteht – ganz ohne irgendwelche Brillen. Auf diese Weise wird man mit hoher Wahrscheinlichkeit auch im Auto „digitale Erlebniswelten“ schaffen, die in die reale Welt integriert werden.

Das Interagieren mit Daten und dem Computer erfordert im Auto ein neues Interface – jenseits der GUI. Das kann ein Sprachdialogsystem sein?

Für mich war das Interagieren mit dem Roboter Pepper ein einschneidendes Erlebnis. Da sind die Sprachdialogsysteme und die Künstliche Intelligenz schon sehr weit. Pepper ist es sogar gelungen, mich zu einem Tanz mit ihm zu motivieren – das ist wirklich keine leichte Aufgabe, nicht nur für Roboter. Allerdings steigt man im Dialog mit den meisten Robotern doch noch oft aus. Es hat noch kein Bot den Turing Test bestanden. Es ist oft interessant mit fortgeschrittenen Sprachdialogsystemen und Conversational UIs zu interagieren. Aber auch nicht dauerhaft. Die Erwartungen sind da groß, sie werden aber in der Wirklichkeit noch oft enttäuscht. Erst wenn der Mensch das Gefühl hat, dass er wirklich eine Art vertrauensvolle Beziehung aufbauen kann, dann werden diese Systeme wirklich in die Breite gehen.

Wovon hängt diese Beziehung ab? Von der Sprachfähigkeit, vom Avatar, von der Persönlichkeit, mit der mir der Computer entgegentritt?

Es hängt sehr viel am Menschsein und am Faktor Empathie, an der sozialen und emotionalen Intelligenz. Bosch hat dazu ein Forschungsprojekt, wo Experten aus unterschiedlichen Disziplinen an der emotionalen und sozialen Kompetenz von Robotern wie Spencer forschen – ein hochspannendes Forschungsfeld. Spencer wurde bereits auf dem Flughafen in Amsterdam eingesetzt, um Passagiere von einem Gate zum anderen zu führen. Da merkt man dann schon, ab wann die Menschen sich auf eine Beziehung mit dem Roboter einlassen und sich von ihm helfen lassen. Das hängt nicht nur von den großen Augen ab, oder dass der Roboter „menschlich rüber kommt“. Es hängt von vielen Faktoren ab, aber vor allem auch davon, wie sich der Roboter auf die unterschiedlichen kulturellen Kommunikationsverständnisse der Passagiere aus den unterschiedlichsten Ländern einstellen kann. Beispielsweise erwarten unterschiedlich Kulturen stets etwas anderes in Bezug auf „Hilfsbereitschaft“ oder ein „höfliches Verhalten“. Der Roboter stößt nur auf Akzeptanz, wenn es ihm gelingt, die konkreten Bedürfnisse zu erkennen und wirklich weiterzuhelfen in einer Art und Weise, dass sich der Mensch „abgeholt“ fühlt.

Um noch einmal auf das Auto zurückzukommen: Müssen wir als Kommunikatoren in Zukunft auch für das Auto spezifischen Content produzieren?

Eine spannende Frage. So schnell wahrscheinlich nicht. Aber natürlich beschäftigen wir uns damit. Das vernetzte, selbstfahrende Auto ist ja ein ideales Szenario, wie man einen Content-Raum der Zukunft bedient – aber das gilt natürlich auch für andere Räume wie die vernetzte Küche.

Im Auto ist es noch einmal besonders spannend, weil man es da mit einem geschlossenen, multisensorischen Medienraum zu tun hat, in dem heute das Radio, aber auch künftig wahrscheinlich Sprache und der Sprachdialog mit Persönlichen Virtuellen Assistenten eine große Rolle spielen. Wenn wir als Kommunikatoren über eine solche „Voice first“-Welt nachdenken, dann stehen viele von uns vor großen Herausforderungen. Viele Print und Video-Formate passen nicht mehr ins vernetzte Auto. Und dann ist natürlich die Frage: Was tritt an deren Stelle? Zum Beispiel dialogische Formate, die natürlich andere Inhaltsformen integrieren – zum Beispiel Video-Content, Musik, Podcasts. Aber wie so ein dialogischer Content aussehen wird, damit experimentieren wir erst, z.B. im Rahmen von Chatbots.

Bei Fahrzeugen mit „Autonomielevel 5“ können wir uns natürlich auch vorstellen, dass das Auto zu einem fahrenden „Kino“ wird. Dabei kann man sich dann auch Mixed Reality Erfahrungswelten im Auto vorstellen. Als Kommunikatoren würden wir uns dann noch intensiver mit immersive Storytelling beschäftigen. Da können wir von den großen Filmproduktionen viel lernen, die längst nicht nur für die Leinwand produzieren, sondern auch für Games oder digitale Erlebniswelten in Freizeitparks. Ich muss sagen: Ich freue mich sehr auf dieses immersive Storytelling im Auto!

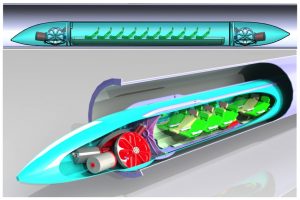

Menschen in der Rohrpost-Kapsel – wird der Hyperloop zum Blueprint für das autonome Fahren?

Sie kennen sicher den Hyperloop. Dabei sollen Menschen kurz gesagt in einem Rohrpostsystem mit Schallgeschwindigkeit transportiert werden. Die Kapseln sind abgeschlossene Räume. Eine Außenwelt müsste man da komplett simulieren – woran auch konkret gearbeitet wird. Ist der Hyperloop ein Modell für das Auto?

Ich hoffe, dass das Auto noch viel größere Möglichkeiten bietet, als der Hyperloop. Das Auto ist für mich auch schon ein wenig ein Ausdruck der Persönlichkeit. Ich denke schon, dass sich viele Nutzer das Auto der Zukunft auch persönlich gestalten wollten. Dabei wird die Mediennutzung sehr unterschiedlich sein. Es gibt sehr unterschiedliche Mediennutzungstypen. Die einen sind sehr visuell, die anderen haben doch ganz gern Text – und sei er auch nur vorgelesen. Das Auto der Zukunft sollte aus meiner Sicht all diese Nutzungsszenarien bedienen können.

Das Auto ist ja nicht nur ein riesiges Medium sondern auch ein riesiger Sensor. Das Auto versendet nicht nur Daten, es sammelt sie auch – und gibt sie weiter. Entsteht hier nicht ein gewaltiges Überwachungsinstrument?

Ich hoffe nicht. Ich möchte jedenfalls mein Leben weiter nach meinen Bedürfnissen gestalten können. Deshalb möchte ich die Wahl haben, was mit meinen Daten geschieht. Warum sollen Daten im Auto nicht ausschließlich zum Zweck eingesetzt werden, das Fahren sicherer zu machen? Wenn ich meine biosensorischen Daten aus dem Auto nicht für andere Zwecke eingesetzt haben möchte, sollte dies auch nicht geschehen.

Sollen die Daten noch für andere Zwecke genutzt werden? Was den Medienkonsum und das Entertainment anbelangt, so unterscheidet sich das Auto kaum vom Zuhause: Es muss aus meiner Sicht in der Verantwortung und Kontrolle des Einzelnen liegen, wie weit er da gehen möchte – und was mit den Daten geschieht, die dabei anfallen.

Daten sind ein Rohstoff und in einem Auto werden sehr viele davon anfallen. Die dürfen nicht nur einem gehören – etwa dem Programmierer des Virtuellen Assistenten. Im der vernetzten Welt geht es darum, einen fairen Ausgleich zu finden, zwischen dem, was mit den Daten gemacht wird, und den Interessen des Einzelnen. Solche Herausforderungen haben wir Menschen in der Wirtschaftsgeschichte aber immer ausgehandelt. Das muss auch jetzt geschehen und da wird es einen gesellschaftlichen Konsens geben, vielleicht mit Daten-Bezahlmodellen oder ganz anderen abgestuften Geschäftsmodellen – das werden wir sehen. Als vor 130 Jahren Berta Benz auf ihre erste Fahrt ging, gab es schließlich auch noch kein Tempolimit. Das müssen wir jetzt auch für die digitale Welt verhandeln.